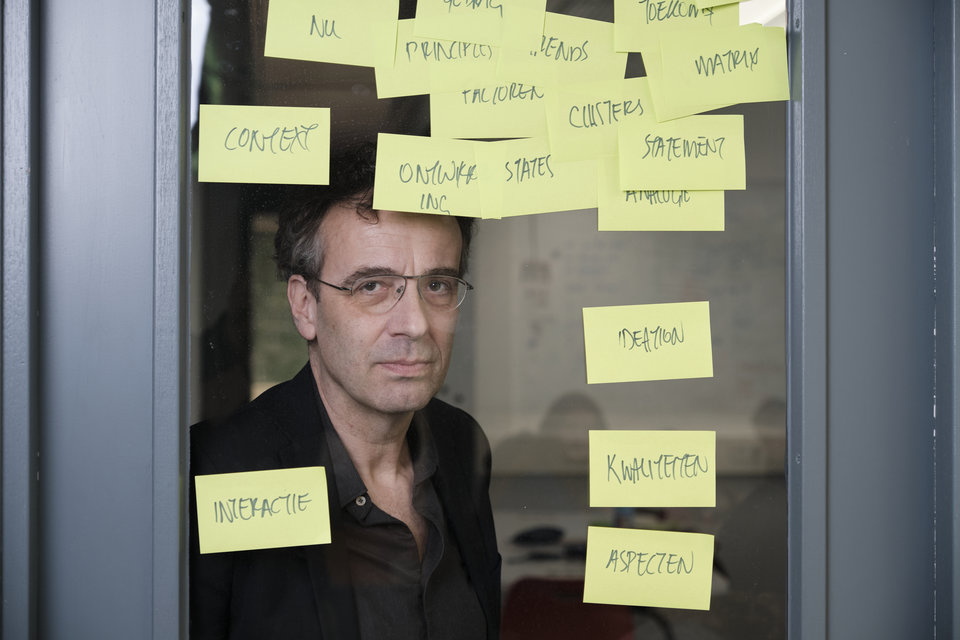

"Algoritmes discrimineren niet uit zichzelf, de sleutel ligt bij de mens: welke data wij erin stoppen, wanneer we een algoritme goed genoeg vinden, wanneer wij ingrijpen en hoe makkelijk wij het maken om in bezwaar te gaan.” Universitair docent Stefan Buijsman onderzoekt hoe we Artificial Intelligence eerlijk en rechtvaardig kunnen inzetten. Hij is positief: "Ik denk dat AI en mensen in goed samenspel onze wereld rechtvaardiger, schoner, gezonder en veiliger kunnen maken."

Sterrenkundige worden, dat was de jongensdroom van Stefan Buijsman. De vlotte vwo-leerling ging op zijn vijftiende sterrenkunde en informatica studeren in zijn geboortestad Leiden: "Ik was en ben nog steeds gefascineerd door onbekend terrein en nieuwe dingen ontdekken. De ruimte sprak tot mijn verbeelding, maar toen ik de formules indook en 20 keer hetzelfde experiment moest herhalen, bleek dat ik er te ongeduldig voor was. Ik kon niet geconcentreerd blijven op het zorgvuldige uitvoeren en wilde meteen verder denken."

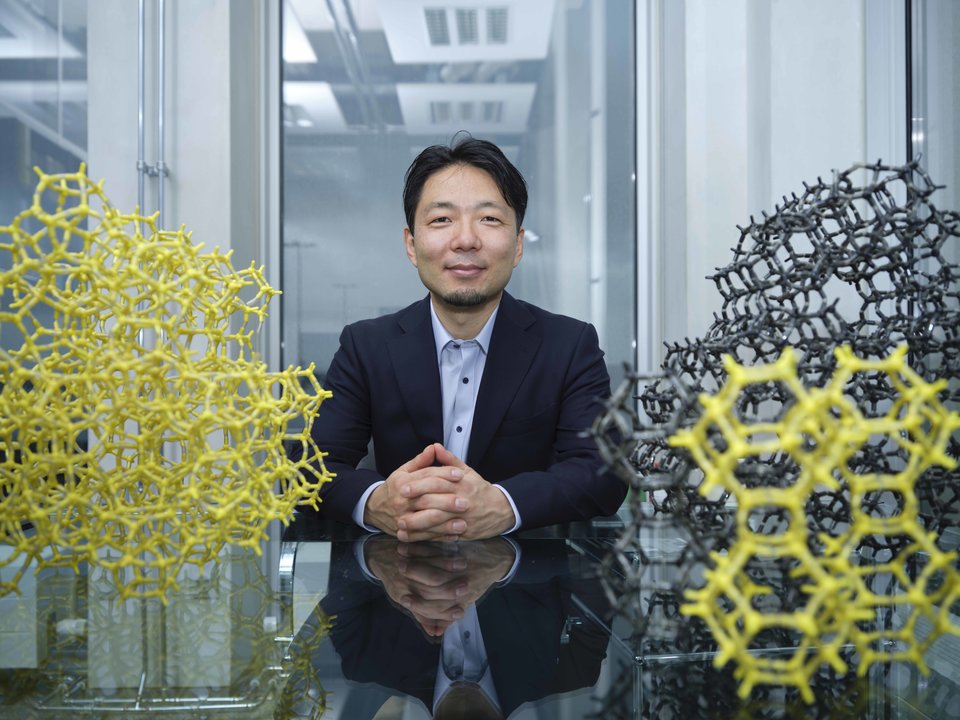

Via een honoursprogramma volgde Stefan Buijsman al filosofievakken. Hij liet sterrenkunde vallen en maakte zijn bachelor informatica af: "Ik had zo veel filosofievakken gevolgd dat ik de master filosofie mocht doen. Daar was ik op mijn achttiende mee klaar. Wat mij in filosofie aanspreekt, is het conceptueel doordenken. Ik wil informatie en kennis van allerlei wetenschapsgebieden bij elkaar rapen en kijken hoe ik die verschillende perspectieven kan samenbrengen tot een antwoord. Met filosofie leg je er als het ware een theoretisch laagje bovenop. Ik zie mezelf meer als een generalist en verbinder, dan een specialistische wetenschapper die alles weet over een onderwerp en de details induikt."

Hoe leren wij wiskunde?

Na zijn afstuderen in Leiden vertrok Buijsman op zijn twintigste naar Zweden. Daar promoveerde hij op filosofie van de wiskunde. Ook schreef hij populaire wiskundeboeken voor volwassenen en kinderen. "Samen met psychologen wilde ik weten hoe kinderen leren tellen en rekenen. Hoe werkt dit in de hersenen? En hoe maak je wiskunde toegankelijk voor niet-wetenschappers, voor gewone mensen? Het was nog steeds vrij fundamenteel onderzoek en niet zo zeer toegepast pedagogisch werk. Na een paar jaar begon het fundamentele te knagen en wilde ik bezig zijn met onderzoek dat direct impact heeft op mensen en de samenleving. Daarom ben ik in mei 2021 ook overgestapt naar de TU Delft, faculteit Techniek, Bestuur en Management."

Buijsman houdt zich op de TU Delft bezig met kennisvraagstukken rondom kunstmatige intelligentie. "Hoe gaan we verantwoord om met AI? Wanneer weten we genoeg van algoritmes om er goed mee om te gaan? Wanneer moeten we een algoritme wel vertrouwen en wanneer niet? En hiermee kom ik ook bij ethische vraagstukken. In Delft ben ik iets praktischer bezig: mijn onderzoek moet toepasbaar zijn; de wereld en mensen moeten er iets aan hebben."

Nabootsen menselijke intelligentie

Een geldautomaat was vroeger een toppunt van kunstmatige intelligentie. Ook al was het slechts een machine die met geprogrammeerde regels, een set instructies, iets deed wat mensen konden doen. Vandaag de dag gaat AI over deels zelfrijdende auto's, gezichtsherkenning, nepnieuws, deepfake, medische diagnoses, muziek en kunst maken. "Kunstmatige intelligentie kun je zien als algoritmes die menselijke intelligentie proberen na te bootsen", legt Buijsman uit. "We maken vooral grote stappen met neurale netwerken, zelflerende algoritmes die geïnspireerd zijn op onze hersenen. Het grootste verschil tussen mensen en computers blijft dat mensen een soort algemeen begrip hebben van hoe de wereld in elkaar zit. Computers hebben dat algemene begrip totaal niet: ze gaan domweg op zoek naar patronen in hele grote hoeveelheden data. Je laat de computer een miljoen plaatjes zien van een hond en dan gaan ze een beetje begrijpen wat een hond is. Maar als je een nieuw ras laat zien of een hond die er net iets anders uitziet, dan snapt de computer niet dat het ook een hond is. AI maakt dan ook fouten die wij als mensen niet maken. De eerste Tesla's herkenden een stopbord dat deels met een sticker bedekt was niet. En erger en zeer racistisch en discriminerend: ze hadden moeite om mensen met een donkere huid die de weg overstaken, te zien als mensen. Computers hebben geen begrip en ze missen sociaal en culturele context. Dingen waar je niet zoveel context voor nodig hebt, doen ze hartstikke goed, maar bepalen of een Tweet wel of niet racistisch is, is veel lastiger, want daar heb je heel veel context bij nodig. Een computer maakt ook geen morele afwegingen, zoals wij doen."

Begrip, transparantie en betrouwbaarheid

Algoritmes geven een uitkomst, zoals deze persoon is wel of geen fraudeur of deze persoon moet je wel of niet aannemen. Buijsman: "Als je dan vraagt waarom niet of wel, dan komt er niet echt een duidelijk antwoord. Je loopt tegen een gigantische berg berekeningen aan en hebt geen flauw idee wat er gebeurt in die computer. Ik wil mensen helpen om te begrijpen waarom een algoritme zoiets zegt en wat je met die uitkomst in de praktijk kunt. Hoe komt zo'n algoritme tot een keuze? Daar wil ik voor transparantie en begrip zorgen. Daarnaast doe ik onderzoek naar de betrouwbaarheid: hoe zeker is het algoritme van zijn uitkomst? Kun je het algoritme wel of niet vertrouwen? Wat kunnen we doen om tot minder fouten te komen en de uitkomsten beter en rechtvaardiger te maken? Hoe voorkomen we discriminatie en seksisme bij kunstmatige intelligentie? Ook wil ik weten hoe mensen en algoritmes beter met elkaar kunnen samenwerken."

Algoritmes missen begrip en context

Bijna dagelijks waarschuwen mensen voor het gevaar van algoritmes. Ze zijn bang dat algoritmes de wereld overnemen of banen inpikken. "Mijn inschatting is dat het over het algemeen veel langzamer gaat dan we denken", nuanceert Buijsman. "Computers kunnen inderdaad een tekst schrijven die niet te onderscheiden is van de tekst van een journalist, maar dat zijn vooral feitelijke stukjes. Voor onderzoeksjournalistiek of de artikelen die maatschappelijk relevante onderwerpen belichten, heb je echte mensen nodig. Ik heb het ook niet zo met neurale netwerken die HR-afdelingen gebruiken bij het aannemen van mensen: computers beoordelen stem, gezichtsuitdrukkingen en woordkeuze en dat leidt tot een inzetbaarheidsscore. Gezichtsuitdrukkingen zijn niet zo makkelijk te interpreteren en context en culturele variatie van gedrag ontbreken bij de beoordeling. En soms ligt het genuanceerder. Het verbannen van naaktfoto's op Facebook leek nobel, maar ook de iconische foto van het rennende Vietnamese napalmmeisje werd verwijderd. Algoritmes snapten de context van de Vietnamoorlog niet."

Beloftes van AI

Buijsman is zich bewust van de gevaren, maar die wegen niet op tegen de beloftes van AI. "Neurale netwerken kunnen saaie routinematige taken van ons overnemen, zodat we meer tijd over houden voor creatieve en uitdagende taken, waarbij begrip en het beoordelen van de sociale en culturele context en het menselijk contact belangrijk zijn. Ook illegale visserij en illegale houtkap kunnen door neurale netwerken worden opgespoord door slim gebruik te maken van heel veel satellietbeelden. AI en neurale netwerken zijn inzetbaar voor longkankerdiagnoses en helpen bij het ontgrendelen van je telefoon via gezichtsherkenning. Spraakassistenten openen een wereld voor mensen die blind zijn. De Tesla kan enigszins zelfstandig rijden, omdat het objecten herkent tijdens het autorijden. Ook YouTube en Facebook kunnen haatzaaiende foto's en video's' van hun platform verwijderen op basis van neurale netwerken. Met AI kunnen we aardbevingen en tsunami's beter voorspellen.

“Gezichtsherkenning via camera's op straat kan helpen bij het opsporen van vermiste kinderen, maar daar denken de Oeigoeren in China anders over, die worden overal gecontroleerd. Het grootste gevaar van kunstmatige intelligentie is ons gebruik ervan. AI wordt een gevaar als we de uitkomsten klakkeloos overnemen, ondanks impliciete discriminatie of ander ongewenst gedrag dat wij mensen er vaak onbewust in hebben geprogrammeerd. Hier moeten we goed over nadenken: wat gaan we hiermee doen en hoe gaan we hier tegenin? Een mooi voorbeeld is een verzekeringsmaatschappij uit Nieuw-Zeeland waar algoritmes automatisch claims toekennen. Bij twijfel, dus als het algoritme nee wil zeggen, wordt er doorverwezen naar menselijke medewerkers die dan zonder computerhulp de claims evalueren. Dan zijn afwijzingen altijd uitlegbaar. De gevaren en beloftes van AI hangen echt van ons af."

Boeken Stefan Buijsman

- Het Rekenrijk, een spannend avontuur over de wondere wereld van de wiskunde.

- Plussen en minnen, wiskunde en de wereld om ons heen.

- AI, Alsmaar intelligenter, een kijkje achter de beeldschermen.