Hoe zorg je ervoor dat een computer precies begrijpt wat iemand zegt, zelfs als diegene de taal niet perfect spreekt? Om dat mogelijk te maken doet Odette Scharenborg (faculteit Elektrotechniek, Wiskunde en Informatica) onderzoek naar automatische spraakherkenning.

Ik wist eigenlijk niks van spraak, maar bij het eerste college wist ik direct dat ik goed zat.

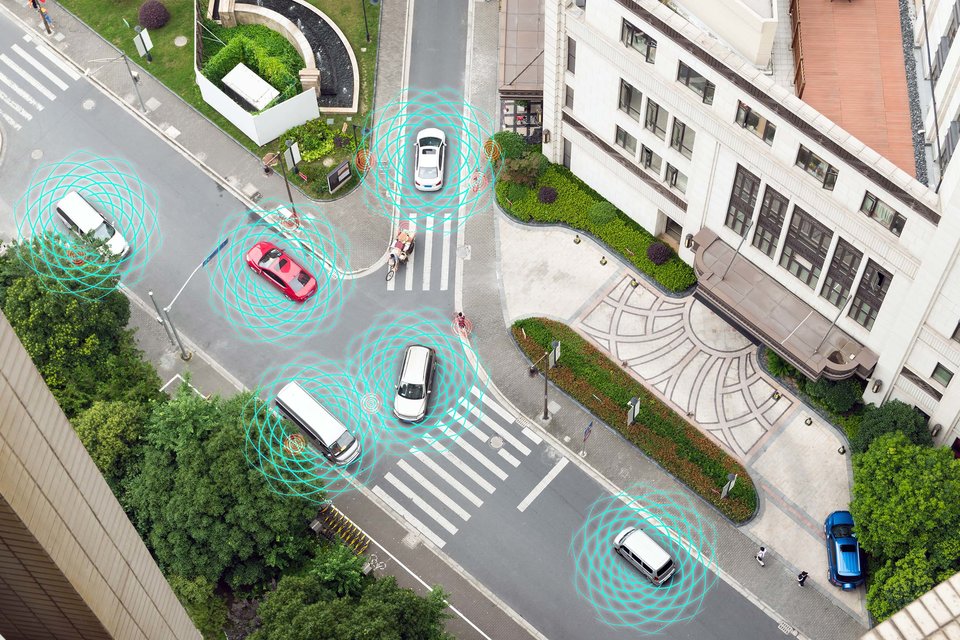

“Siri, zoek de snelste route naar huis.” Zo’n opdracht geven in een stille ruimte is een makkie voor de virtuele assistent van Apple, die je vindt op mobiele telefoons en tablets. Maar stel dezelfde vraag in een druk restaurant of met een zwaar Limburgs accent en Siri zal een stuk moeilijker begrijpen wat je net hebt gezegd. Dat is geen toeval. Spraakherkenners werken momenteel alleen goed als diegene die tegen ze praat duidelijk te verstaan is, een redelijke standaarduitspraak heeft en er weinig achtergrondgeluid is.

Is dit niet zo? Dan lopen we tegen de limieten van de huidige techniek aan, niet alleen bij Siri maar ook bijvoorbeeld bij Google of Amazon die soortgelijke software gebruiken.

“Mensen met een spraakgebrek, ouderen of iemand die vanwege een ziekte niet duidelijk kan praten, schieten weinig op met de huidige spraakherkenning. Terwijl zij er juist vaak baat bij hebben, bijvoorbeeld om te communiceren met vrienden en familie of door apparaten aan te sturen,” zegt Odette Scharenborg. Zij onderzoekt als associate professor aan de faculteit EWI (TU Delft) automatische spraakherkenning, waarbij ze kijkt naar hoe je een computer kunt leren om beter talen te herkennen.

Psychologie van taal

De huidige technologie werkt vooral dankzij een enorme bak data, die gebruikt wordt om spraakherkenners te trainen. De 'bak met data' bestaat uit twee delen: spraak en een tekstuele beschrijving (woord voor woord) van wat er gezegd is (de transcriptie). Er worden opnames gemaakt van de spraak van bijvoorbeeld mensen die gesprekken voeren, teksten voorlezen, tegen een robot of computer spreken of een interview of college geven. Al die uren aan audiomateriaal worden dan uitgeschreven en er wordt aangegeven waar er achtergrondgeluid is of waar geluiden gemaakt door de spreker, zoals lachen of smakken, voorkomen. Maar dit systeem schiet tekort. Het is simpelweg niet mogelijk (qua tijd, geld en inspanning) om voor alle talen en alle accenten genoeg data te verzamelen en te transcriberen. Mede daardoor lag de focus bij het verzamelen van data op de ‘gemiddelde mens’ en zijn bijvoorbeeld ouderen en kinderen niet goed vertegenwoordigt. Bovendien is het voor mensen met een spraakgebrek soms moeilijk en vermoeiend om veel in te spreken. Ook wat iemand met een buitenlands accent zegt, wordt vaak niet goed herkend vanwege een gebrek aan trainingsdata.

En dan zijn er ook nog ongeschreven talen, die toch veel worden gesproken. “Neem het Mbosi in de sub-Sahara, een taal die door zo’n 110.000 mensen wordt gesproken. Van die taal is, voor de huidige spraakherkenners, niet genoeg trainingsmateriaal voorhanden. Daarnaast is het grootste probleem dat om een spraakherkenner te trainen niet alleen de spraakdata nodig is maar ook een transcriptie in tekst van wat er gezegd is. Natuurlijk kan je veel opnemen, maar behalve dat het veel tijd en geld kost, is de transcriptie in tekst van wat gezegd is niet mogelijk bij een ongeschreven taal,” zegt Scharenborg.

Is het mogelijk om een nieuwe manier van spraakherkenning te ontwikkelen, die geen gebruik maakt van tekstuele transcripties, waardoor groepen niet meer buiten de boot vallen? Dat onderzoekt Scharenborg momenteel. Zij kijkt op een fundamentele manier naar automatische spraakherkenning. Daarbij gaat het bijvoorbeeld om hoe je klanken herkent en indeelt. Ook neemt ze de psycholinguïstische kant, de psychologie van taal, mee.

Bij haar huidige onderzoek combineert Scharenborg inzichten uit de psycholinguïstiek met de technologie van automatische spraakherkenning en deep learning.

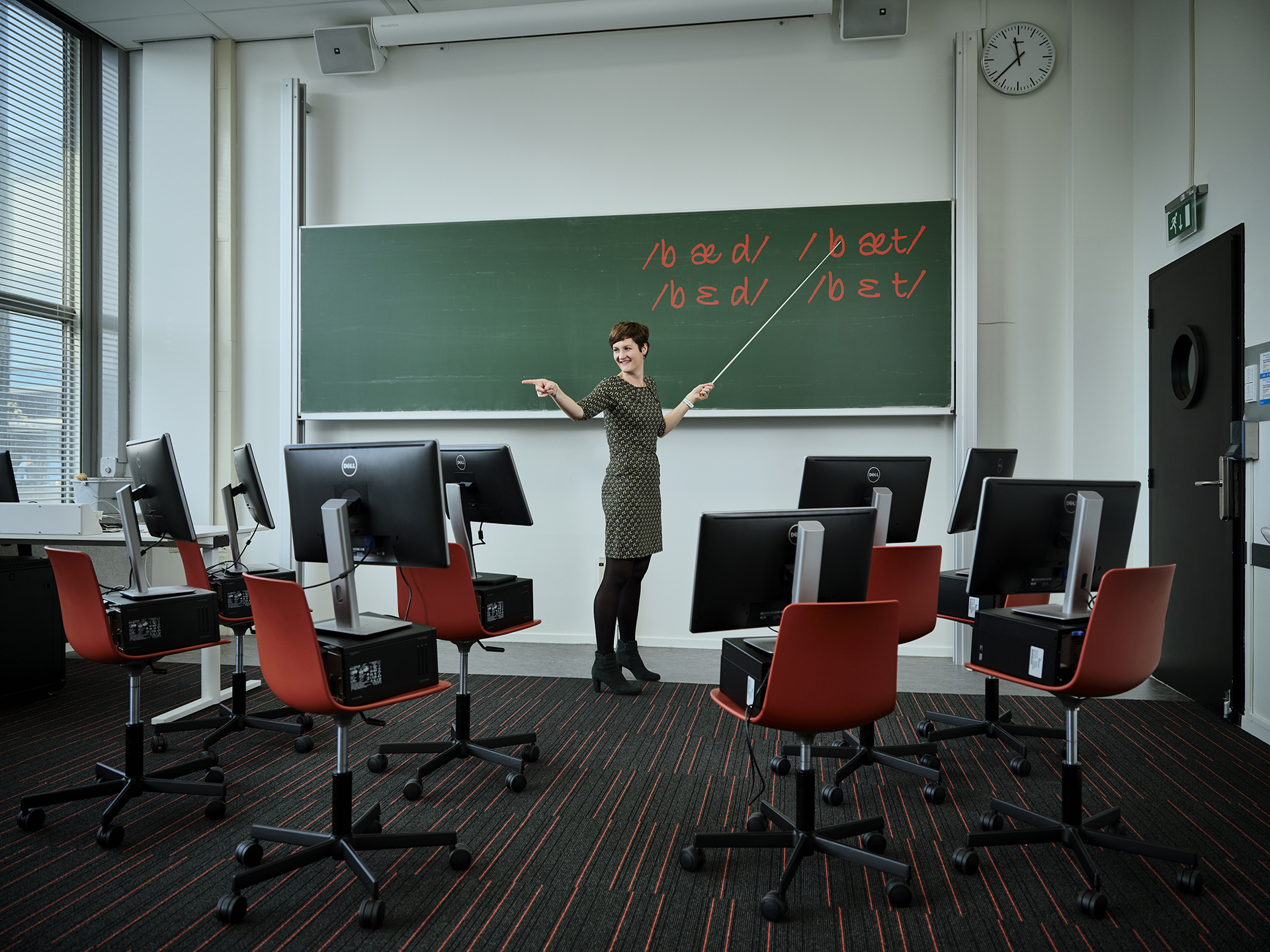

Nieuwe klankklassen

In een van de methodes die Scharenborg onderzoekt kijkt ze naar de verschillen en overeenkomsten in klanken van talen. Elke taal heeft zijn eigen set van klankklassen en uitspraak hiervan. Neem de uitspraak van bed, bet, bat of bad in het Engels. “Als een Nederlander deze woorden uitspreekt, zal het bij veel mensen hetzelfde klinken. Maar zo niet bij een Engelsman, voor wie dit vier verschillende woorden met vier andere uitspraken zijn,” aldus Scharenborg.

Dus zelfs bij een taal als Nederlands en Engels waarbij er veel overlap is, komen verschillende klanken voor (de klinker in bed en bad) en wordt soms eenzelfde klank anders uitgesproken (de d en t op het einde van een woord klinken hetzelfde in het Nederlands maar verschillend in het Engels). “Bij het ontwikkelen van een spraakherkenner voor een ongeschreven taal kun je overeenkomsten tussen talen uitbuiten. Bijvoorbeeld, de Nederlandse e klinkt ongeveer als de Engelse e, maar de a van bat zit qua klank tussen de Nederlandse a en de e in. Die kennis kun je gebruiken om een model van de Engelse a te trainen op basis van een model voor de Nederlandse e,” legt Scharenborg uit.

Wanneer we een nieuwe taal leren, maak je nieuwe klankklassen aan. Bijvoorbeeld als je als Nederlander het Engelse the leert. Dat is geen de en geen te, die wij kennen, of de eerder genoemde a in bad en bat. Dat je dan een nieuwe klankklasse aanmaakt, willen de onderzoekers de computer ook leren. Zodat spraakherkenning in de toekomst zelf leert om op deze manier talen te leren en uitspraken te herkennen, ook al wijken die af van het gemiddelde.

Kluisdeur

Deze aanpak is gebaseerd op experimenten die Scharenborg bij menselijke luisteraars deed. Daarbij luisterden proefpersonen met een koptelefoon op naar klanken. “De l en r zijn twee aparte klankklassen, maar die kan je ook artificieel mengen. Dan klinkt de klank die je uitspreekt bijvoorbeeld net zoveel als een r en als een l. Wij gaven proefpersonen woorden, met als laatste letter de klank die tussen de r en de l in zit. Als je dan het woord peper/l aanbiedt, interpreteren ze de klank als een r, omdat ze er peper, wat ook echt een woord is, van kunnen maken. Daarna gaan proefpersonen het ook als een r classificeren. Het omgekeerde gebeurt als dezelfde klank aangeboden wordt in taker/l, dan zullen mensen diezelfde ambigue klank als l interpreteren, omdat takel een woord is en taker niet. In jouw hoofd pas je dit dus aan.”

Voor dit soort luisterexperimenten zitten proefpersonen in een ruimte, die hier speciaal voor is ontwikkeld. Op de begane grond van het gebouw voor de Wiskunde & Informatica laat Scharenborg een cabine zien die ongeveer het formaat heeft van een tuinhuisje. Ze doet de zware, brede deur open. Het lijkt wel een kluisdeur, zo dik is het. “Hier binnen doen we experimenten. Hier is geen afleiding van andere geluiden. Voel je de druk op je oren? Dat komt omdat de ruimte geluidsarm is,” zegt Scharenborg.

Met de data die de wetenschappers bij de test verzamelen maken ze een nieuw model, dat uiteindelijk moet leiden tot betere spraakherkenning. Daarbij maakt het model zelf de inschatting of er een nieuwe klankklasse nodig is en hoef je dat niet meer in te voeren. Dat is een grote stap voorwaarts voor de automatische spraakherkenning.

In het huisje staan een stoel en een bureau. Daarop ligt een koptelefoon en bevindt zich een computer. Op het scherm lezen proefpersonen bijvoorbeeld woorden en via de koptelefoon horen ze klanken. Ook is er een raam. Zodat de testers altijd contact kunnen maken met een begeleider en diegene ziet of alles goed gaat.

Met de data die de wetenschappers bij de test verzamelen maken ze een nieuw model, dat uiteindelijk moet leiden tot betere spraakherkenning. Daarbij maakt het model zelf de inschatting of er een nieuwe klankklasse nodig is en hoef je dat niet meer in te voeren. Dat is een grote stap voorwaarts voor de automatische spraakherkenning. Het model is geïnspireerd op ons brein en ons diepe neurologische systeem, geeft Scharenborg aan. Een deep neural net, heet dat in het Engels. “Wij zijn de eersten die naar zelflerende spraakherkenners kijken. Samen met een collega in de Verenigde Staten ontwikkelen we daar nu technologie voor. Ik verwacht de eerste resultaten binnen twee jaar.”

Bruggenbouwer tussen alfa’s en beta’s

Leidt dat al snel tot een goed werkend systeem dat Siri naar de kroon steekt? Daarvoor moeten we niet te hard van stapel lopen. De technologie staat nog in de kinderschoenen. Het onderzoek van Scharenborg is grotendeels fundamenteel van aard. Het legt daarmee wel de basis voor een nieuw type automatische spraakherkenning. Een perfect werkend programma is nog iets van de verre toekomst.

In een afgerond NWO Vidi-onderzoek deed Scharenborg ander onderzoek naar spraakherkenning. “Je kent het wel dat je iemand waarmee je praat slechter verstaat als er lawaai is. Dit wordt nóg lastiger als je niet in je moedertaal spreekt, maar in een andere taal, bijvoorbeeld als je op vakantie wat te drinken wilt bestellen in een druk café. Maar waarom is het nou zoveel lastiger om elkaar te verstaan als er achtergrondgeluid aanwezig is? En waarom is dit moeilijker in een vreemde taal dan in je moedertaal? Dat wilde ik graag weten en leidde ertoe dat ik meer kennis opdeed over spraakherkenning door mensen.”

Bij haar huidige onderzoek combineert Scharenborg dus inzichten uit de psycholinguïstiek met de technologie van

automatische spraakherkenning en deep learning. Dat zijn vakgebieden die normaal gescheiden werken. De psycholinguïstiek bestaat voornamelijk uit alfa’s en gamma’s en richt zich op de taal en spraak en hoe onze hersenen woorden herkennen. Terwijl spraakherkenning en deep learning gaan over technologie en hoe je bijvoorbeeld met techniek een zelflerend systeem maakt.

“Om verder te komen moeten we beide vakgebieden combineren. Ik vind het een beetje vreemd dat niet meer mensen dit combineren. Het doel van mensen en machines is hetzelfde, namelijk het herkennen van woorden,” aldus Scharenborg.

Wetenschappers van de twee vakgebieden kennen elkaar zelfs vaak helemaal niet. Daar wil Scharenborg verandering in brengen. Ze is al jaren betrokken bij de organisatie van de grootste conferentie over spraakherkenning, die beide gemeenschappen samenbrengt. “Beide groepen focussen nog teveel op hun eigen vakgebied. Voor technische wetenschappers die zich bezighouden met deep learning is spraak een soort data, die ze gebruiken om technologie te ontwikkelen. Terwijl onderzoekers van psycholinguïstiek juist vaak relatief weinig weten van computers. Ik ben van mening dat de vakgebieden elkaar aanvullen en veel van elkaar kunnen leren, zowel van de kennis over spraak als over computersystemen. Ik wil ze met elkaar in gesprek laten gaan.”

De huidige technologie werkt vooral dankzij een enorme bak data, die gebruikt wordt om spraakherkenners te trainen.

De Knight Rider

Scharenborg heeft ruime ervaring met beide vakgebieden en wil daarom bruggenbouwer zijn. Voordat ze onderzoek deed aan de TU Delft was ze associate professor bij de afdeling Taalwetenschap aan de Radboud Universiteit. “Ik kom uit de spraakherkenning, maar ik heb me ook bezig gehouden met de psycholinguïstiek. Het is logisch dat ik nu bij de TU Delft mijn onderzoek doe, want hier zit de technische expertise en wordt interdisciplinair onderzoek gedaan. Daardoor voel ik mij geen buitenbeentje, ook al ben ik vrijwel de enige wereldwijd die dit onderzoek doet.”

Al op de middelbare school was Scharenborg goed in alfa- en beta-vakken. “Ik wist niet goed wat ik moest studeren en koos daarom een opleiding die zich richtte op taal, spraak en informatica bij de Radboud Universiteit. Ik wist eigenlijk niks van spraak, maar bij het eerste college wist ik direct dat ik goed zat. Bijna iedereen praat met elkaar en veel communicatie gaat via spreken met elkaar. Je kunt het natuurkundig bekijken door je te richten op golfjes die spraak voortbrengt, maar ook nagaan hoe mensen het herkennen. Het spreekt mij zo aan dat je het van verschillende kanten kan benaderen.”

Zonder dat ze het vroeger zo doorhad, was ze toen ook al bezig met spraak. “Ik vond bijvoorbeeld de televisieserie Knight Rider geweldig. Daarin speelde David Hasselhoff held Michael Knight die kon praten met zijn auto KITT. Deze superwagen begreep niet alleen wat er gezegd werd. Hij praatte ook nog eens terug en was intelligent. En als Knight en KITT niet bij elkaar in de buurt waren, communiceerden ze via een horloge. Dat vond ik vroeger al heel interessant, die fascinatie is nooit verdwenen. En nog altijd ben ik met spraak en technologie bezig.”

Tekst: Robert Visscher | Foto Odette: Frank Auperlé, foto’s cabine: Dave Boomkens.