Waar algoritmes vliegtuigen in de lucht houden en straks ook zelfrijdende auto’s op de weg, komen burgers dankzij toenemende algoritmische besluitvorming bij de overheid steeds vaker onder de spreekwoordelijke tram. Tenzij we lessen uit de systeem- en regeltechniek vertalen naar de ontwikkeling en het beheer van publieke algoritmische systemen, zoals Roel Dobbe doet.

Het toeslagenschandaal en de rol van het SyRI systeem voor de bestrijding van uitkeringsfraude zijn slechts twee recente voorbeelden van een bui die Roel Dobbe tien jaar geleden al zag hangen. Hij zei de consultancy vaarwel en besloot in Berkeley te promoveren op de maatschappelijke implicaties van data-gedreven technologie. Zo kon hij de lessen die hij opdeed in de systeem- en regeltechniek om complexe processen te optimaliseren nog directer ten goede van de maatschappij inzetten.

‘We moeten heel goed nadenken voordat we automatisering toepassen op kritieke infrastructuur – een brug of elektriciteitsnetwerk, maar bijvoorbeeld ook sociale zekerheid. Want naast een grotere kans op fouten, kan een fout, zeker in het sociale domein, ook heel snel heel veel mensen raken. Mijn standpunt hierin is best wel controversieel: Als we niet kunnen aantonen dat zulke systemen in lijn zijn met publieke waarden en voldoen aan concrete criteria voor veiligheid en rechtvaardigheid, dan moeten we ze niet loslaten in de maatschappij.’

Grip

De opkomst van kunstmatige intelligentie (AI) in het publieke domein, naast “traditionele” regel-gebaseerde algoritmes, maakt het allemaal nog veel complexer omdat daar miljarden of zelfs biljoenen parameters inzitten. Dobbe: ‘Niemand weet echt goed hoe het werkt en wat er allemaal fout kan gaan. En als ambtenaar heb je weinig tot geen grip op het ontwerp om zaken als veiligheid en rechtvaardigheid recht te doen. Je begeeft je als publieke organisatie echt op glad ijs als je AI inzet, maar we zien helaas dat het geloof in inherent problematische toepassingen hoog blijft.’

We moeten heel goed nadenken voordat we AI of automatisering toepassen op kritieke infrastructuur zoals een elektriciteitsnetwerk of sociale zekerheid.

Wat Dobbe betreft, biedt de systeem- en regeltechniek broodnodige inzichten om de ontwikkeling, het bestuur en het toezicht op publieke algoritmische systemen in goede banen te leiden. ‘Het perspectief van systeemveiligheid is oorspronkelijk ontwikkeld om een vliegtuig in de lucht te houden en veilig van A naar B te brengen. Maar het is zeker ook goed toepasbaar op energiesystemen, in de gezondheidszorg en op sociale zekerheid. In beleid en de automatisering daarvan wordt nu nog heel erg op verantwoording en transparantie gestuurd. Dat is zeker nuttig, maar het biedt geen garantie dat de systemen goed werken en dus tot veilige en rechtvaardige uitkomsten leiden.’

Een socio-technisch perspectief

Behalve het algoritme zelf gaat het bij systeemveiligheid juist ook om de organisatie (met al zijn complexiteit) daaromheen waarin het geïmplementeerd wordt en die op basis daarvan beslissingen neemt. Dobbe: ‘Waar, door wie en hoe wordt het gebruikt? Hoe zit het met toezicht? En als het mis gaat, wat zijn dan de mogelijkheden voor de burger om bezwaar te maken, om de impact te minimaliseren en schade te herstellen? We kijken dus niet alleen vanuit technisch perspectief maar ook vanuit de sociale, bestuurs- en geesteswetenschappen naar systeemveiligheid: een socio-technische benadering dus.’

Cultuur speelt in de systeemveiligheid een cruciale rol. ‘Het is al lang bekend dat een veiligheidscultuur, waarin je issues kunt bespreken zonder dat je daarvoor wordt bestraft, van essentieel belang is. Zo voorkom je dat een klein issue uitgroeit tot een groot risico en ongelukken. We zien nu bij de Belastingdienst hoe erg dat fout kan gaan. Door de angstcultuur is het niet meer mogelijk om het belang van de gedupeerden van het toeslagenschandaal centraal te houden en ondervinden deze burgers additioneel leed.’

Tunnelvisie

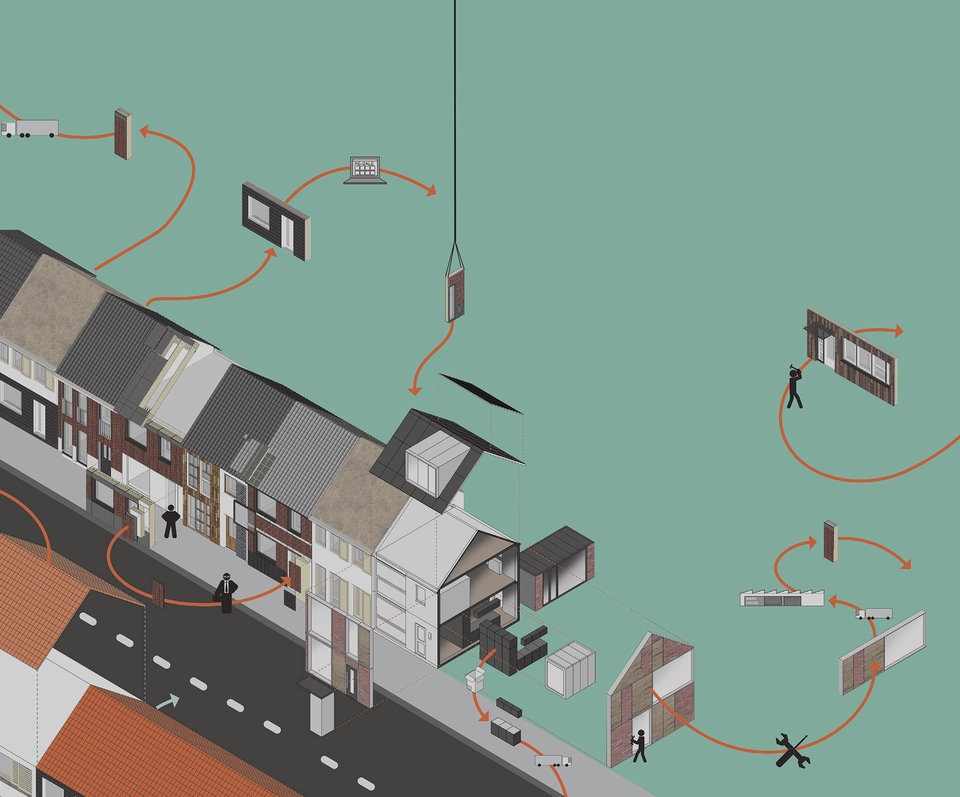

In het sociale domein is er nog niet zo’n traditie van systeemveiligheid. Dat dit nut heeft, bleek bijvoorbeeld toen Dobbe en een afstudeerder met deze blik naar de Wajong regeling keken. Daarin worden beslissingen deels geautomatiseerd en deels door mensen genomen, daarbij al dan niet ondersteund door algoritmes. Dobbe: ‘Het bleek dat problemen voor de burger vooral ontstaan als er door de ene organisatie, zeg de Belastingdienst, aan de knoppen van een algoritme wordt gedraaid, zonder na te gaan wat dat voor gevolgen heeft voor de regelingen en algoritmes bij andere instellingen, zoals het UWV of de Sociale Verzekeringsbank. De burger wordt vervolgens de dupe van al dit soort rimpeleffecten.’

Momenteel worden veel regels bedacht om het individuele algoritme verantwoord te ontwerpen zonder deze rimpeleffecten en de implicaties voor de burger in oogschouw te nemen. ‘Ik zie het als mijn taak om beleidsmakers wakker te schudden, te laten zien dat ze een ander perspectief nodig hebben en daar ook concrete tools en oplossingen voor te ontwikkelen.’

Nog steeds pionieren

Dat is allesbehalve eenvoudig en ook na tien jaar nog steeds pionieren, vindt Dobbe. ‘Ik ben niet voor niks vanuit de VS naar Delft teruggekomen. Het is ook logisch dat ik bij de faculteit Techniek, Bestuur en Management zit. De combinatie van mijn inzichten in de systeem- en regeltechniek met de socio-technische aanpak van TBM biedt een adequaat perspectief voor dit soort problematiek.’

Een deel van zijn onderzoek is heel empirisch. ‘We sturen onze promovendi en afstudeerders organisaties in om te begrijpen hoe een situatie eruitziet. Welke systemen er zijn, welke regelingen en beleidsuitdagingen? Specifiek voor AI-systemen kijken we naar de trade-offs die daarbij komen kijken. Welke publieke waarden komen met elkaar in conflict en wat is de concrete impact voor burgers en professionals?’

Af en toe moet je hard op de rem trappen als een AI-systeem gewoon niet de oplossing is of inherent onveilig of onrechtvaardig.

Daarnaast doet hij onderzoek naar Machine Learning (een vorm van AI). ‘We kijken hoe we dat “socio-technischer” kunnen doen. Hoe zorgen we er bijvoorbeeld voor dat die zeer technische wereld ook rekening gaat houden met beleid en regulering, met alle sociale issues die er ontstaan als je een machine-learning model daadwerkelijk in de praktijk gaat gebruiken?’ Een belangrijk vraagstuk daarbij is hoe je veiligheid en betekenisvolle menselijke controle definieert en waarborgt op het snijvlak van algoritmes, de mens / gebruiker, en instituties. ‘Dat vergt een samenkomst van verschillende disciplines maar vooral van de actoren die er in de praktijk mee bezig zijn. Dit jaar bouwen we daarvoor aan een Transdisciplinair Expertisecentrum voor Rechtvaardige Publieke Algoritmische Systemen, gevestigd in Den Haag samen met verscheidene overheden, maatschappelijke partijen, bedrijven en kennisinstellingen.’

Gaaf en eervol

Dankzij zijn pionierswerk wordt Dobbe veelvuldig door partijen in het publieke domein gevonden en geraadpleegd. Zo stond hij in het openbaar bestuur al (mede) aan de wieg van de nieuwe algoritmewaakhond en het algoritmeregister en introduceerde hij met zijn groep kennis over systeemdenken bij het consortium voor “Publieke Controle op Algoritmes” – een groot aantal publieke organisaties door het hele land dat bouwt aan oplossingen, gesteund door het Ministerie van Binnenlandse Zaken. Daarnaast pakt hij vergelijkbare vraagstukken op over het introduceren van kunstmatige intelligentie in energiesystemen en in het gezondheidsdomein. Zo weet hij lessen over domeinen heen te delen.

Voorlopig heeft hij nog geen genoeg van zijn rol als wetenschapper op deze urgente en dynamische maatschappelijke thema’s. ‘Het is gaaf en eervol om vanuit prangende vragen in de maatschappij zowel nieuwe wetenschappelijke kennis te ontwikkelen als ook praktische kaders en handvatten aan te bieden,’ zegt hij. ‘En af en toe ergens hard op de rem trappen als een AI-systeem gewoon niet de oplossing is of inherent onveilig of onrechtvaardig.’